Les 3 types d’intelligences artificielles

Le problème de l’IA c’est qu’une fois qu’elle fonctionne bien on arrête de l’appeler « IA ». Ça devient un truc intégré à nos quotidiens. Par exemple personne ne pense à Google Maps comme étant une « IA », alors que c’est une IA assez bluffante. Elle est capable de te dire quel chemin prendre et de s’adapter aux embouteillages en temps réel.

Sauf que… comme elle fonctionne parfaitement on ne dit plus que c’est une IA.

Du coup, on a tendance à voir l’IA comme un truc un peu foireux.

L’autre souci c’est que y’a des degrés d’IA. Mais que dans nos têtes on imagine direct le degré ultime. Alors à chaque fois qu’on nous dit ça y est, une IA fonctionne on constate que c’est pas comme dans les films et donc c’est nul.

On va ici prendre le temps de décrire trois degrés d’intelligence artificielle. Je vais paraphraser un article de Waitbutwhy qui s’appelle :

The AI Revolution: The Road to Superintelligence

Mais avant ça…

Avons-nous une intelligence spéciale ?

Certaines personnes sont convaincues, par principe, que les humains ont un truc spécial qui empêche d’arriver à leur hauteur. Une âme. C’est le cas de Raphaël Enthoven qui va déclarer, par exemple, qu’une machine est incapable d’écrire la problématique d’une dissertation de philo et que même dans 1000 ans elle en sera toujours incapable.

Mon plaisir coupable c’est quand, 1 mois après qu’il ait dit ça… on lui a montré que GPT pouvait le faire. Et il a dit ok mais il saura jamais penser quand même.

Quand j’entends ce genre de raisonnement je me rappelle toujours qu’on a cru que notre planète était le centre de la galaxie.

En plus, comme on est centré·es sur nous-mêmes, on a une énorme sensibilité aux différences d’intelligence entre nous. De la même manière qu’on voit très facilement nos différences physiques alors qu’on confond les grenouilles et les crapauds qui sont deux espèces qui n’ont rien à voir entre elles.

On a l’impression qu’entre Einstein et une personne lambda y’a une différence énorme d’intelligence. Mais au final pas tant que ça. Ce n’est pas comme la différence entre un humain lambda et une araignée par exemple.

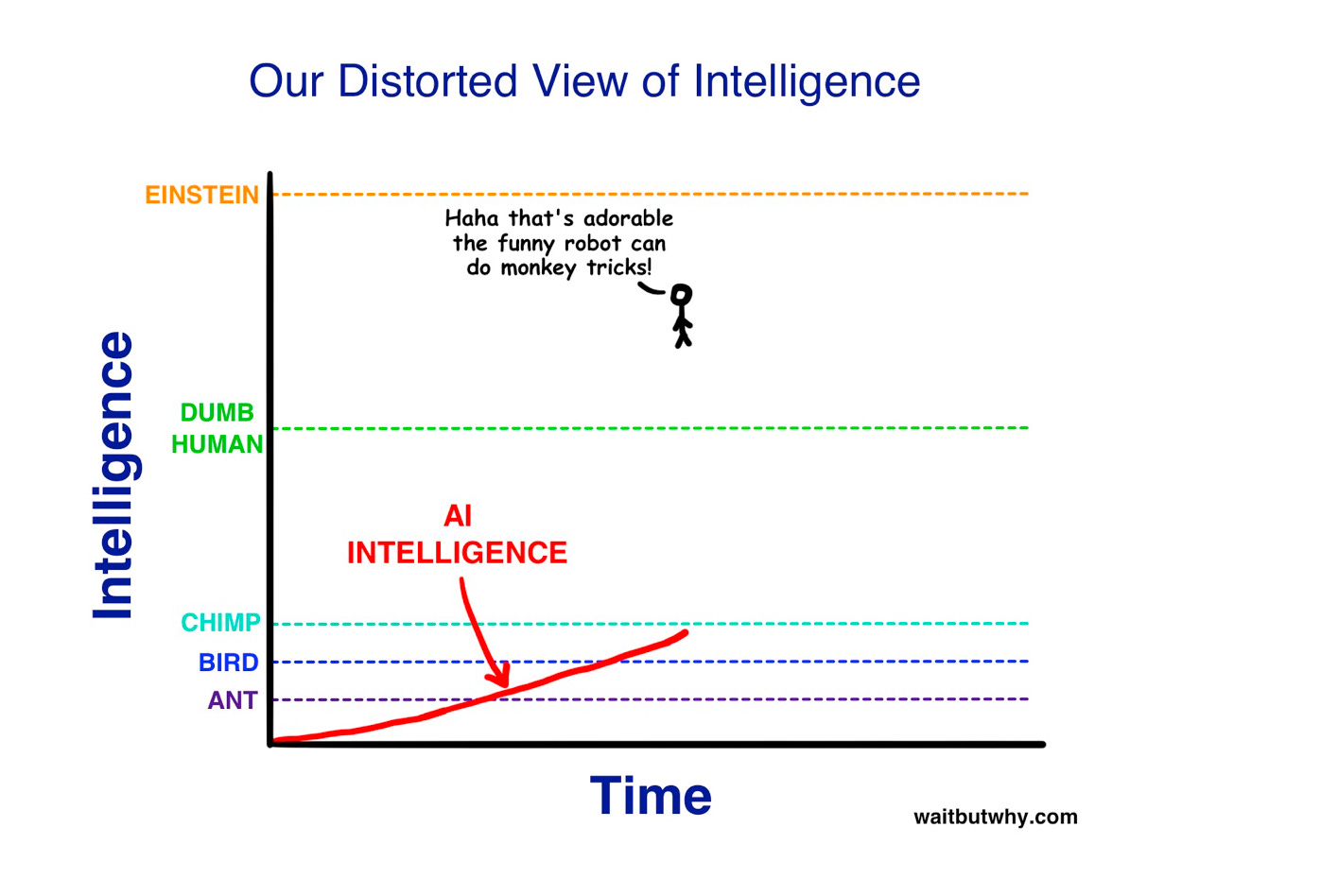

Comme l’illustre Tim Urban du blog Waitbutwhy… on a l’impression que l’écart entre Einstein et un humain peu intelligent et aussi grand qu’entre l’humain lambda et un chimpanzé. Comme ça :

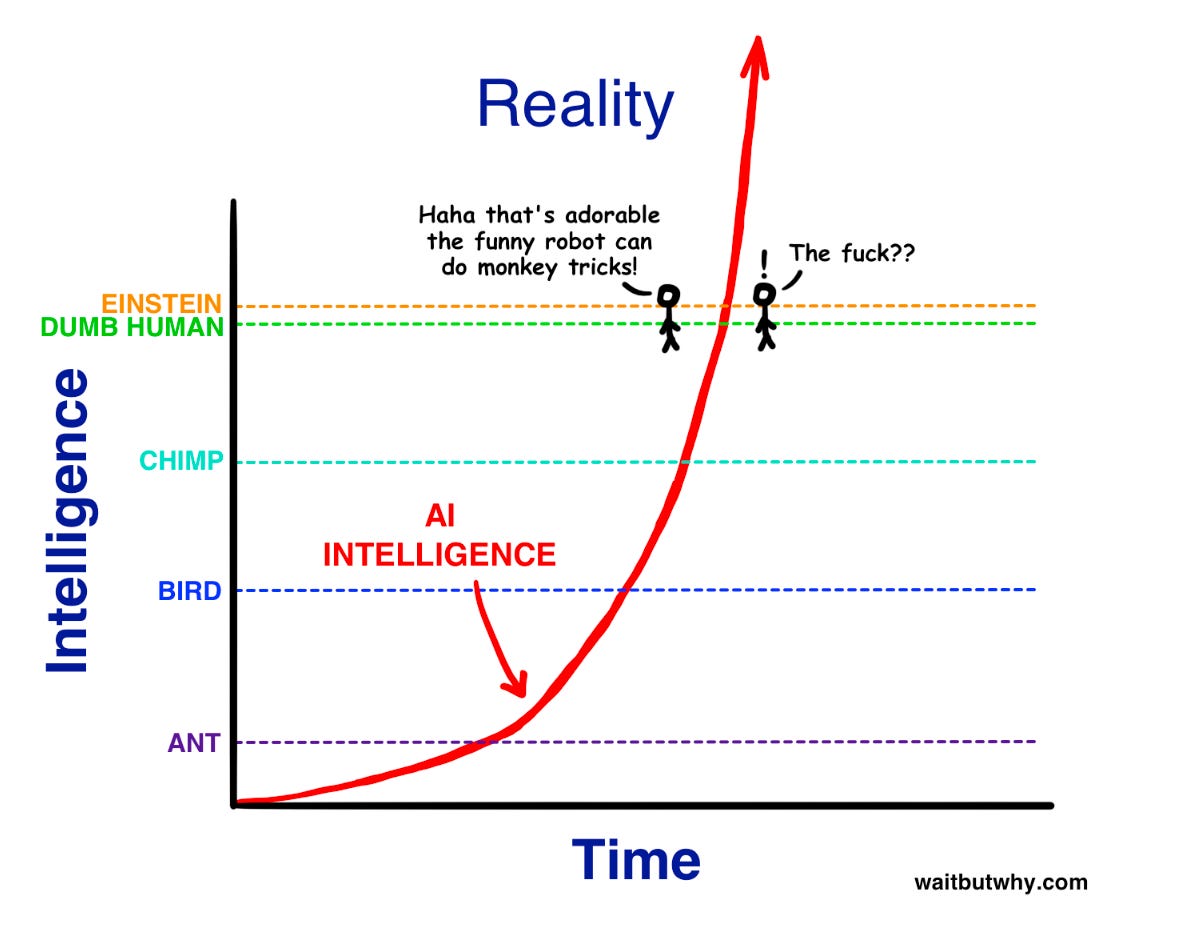

Alors qu’en fait c’est plutôt comme ça :

En réalité la différence entre un chimpanzé et un humain lambda est énorme. Et celle entre Einstein et lui, n’est pas SI grande.

Parce que nous ne sommes pas un point spécial. Einstein n’est, en toute probabilité, pas le point ultime de l’intelligence.

En tout cas c’est ce que pensent les gens qui, comme moi, ne voient pas pourquoi les humains seraient spéciaux.

Et puis… pourquoi serait-il impossible de créer un ordinateur aussi intelligent que nous à partir d’une matière inanimée ? Au final c’est quoi notre cerveau si ce n’est un ordinateur intelligent construit à partir d’une matière inanimée ?

C’est là que revient le concept de l’âme. Il y aurait un truc en plus que notre cerveau qui permettrait cette intelligence.

Mais revenons aux IA. Voici la graduation qu’on retrouve le plus souvent : ANI, AGI, ASI.

Niveau #1 : l’ANI

Ici le N est pour Narrow donc Intelligence Artificielle Étroite.

Une IA Étroite c’est une IA qui sait faire une seule chose aussi bien qu’un humain, voire mieux.

C’est le niveau #1. Par conséquent, la première partie de la course à l’IA était composée de plein de courses à qui fera l’IA étroite efficace d’un secteur précis.

Tu te rappelles de tout le boucan autour de Deep Blue, l’IA qui a battu le champion du monde d’échecs Kasparov en 1997 ?

Bon… il se trouve que Deep Blue a triché dans sa démonstration. En 1997 les IA d’échecs n’avaient absolument pas surpassé Kasparov. Pouvoir battre Kasparov une fois ça veut pas dire le surpasser. N’importe qui s’y connaissant en sport le sait.

En revanche, depuis, c’est fait. Stockfish, par exemple, est si fort que même Kasparov à son meilleur niveau serait incapable de rivaliser.

Pour te donner une idée, le meilleur niveau aux échecs c’est dans les 2800 elo (l’échelle de puissance). Kasparov a atteint les 2851. Personne n’a atteint les 2900. À un moment on se demandait même si 3000 n’était pas LA limite objective.

Encore une fois l’arrogance des humains qui se sentent spéciaux et se disent que si on arrive pas à atteindre 2900 c’est que c’est pas loin du niveau maximal.

Aujourd’hui Stockfish atteint facilement les… 3550.

Pour te donner un ordre de grandeur… une différence de 400 elo ça veut dire que la personne va gagner quasiment 100% des fois. Donc, en d’autres termes ça veut dire que Stockfish peut battre à plate couture un ordinateur qui battrait Kasparov à plate couture.

On en est là.

Le fossé ne sera jamais rattrapé. L’IA étroite spécialisée dans le jeu d’échecs est parachevée.

Mais… Stockfish n’est pas capable de faire une dissertation ou même tenir une conversation basique : il ne sait QUE jouer aux échecs.

Et des Stockfish de leur domaine y’en a plein aujourd’hui :

Google Translate

Le logiciel qui fait atterrir les avions

Le logiciel qui cible précisément la publicité, tellement précisément que tu crois que ton téléphone t’écoute

Etc

À une époque on trouvait ça incroyable d’avoir une IA comme ça. Quand Deep Blue a battu Kasparov c’était un événement mondial. Maintenant… on s’y est habitué·es. On attend le niveau 2.

Il est probable que tu aies été surpris·e en lisant que Google Translate est une IA par exemple : parce qu’elle marche. Une IA qui marche vraiment n’est plus considérée comme une IA.

Niveau #2 : AGI

Ici le G c’est pour Générale.

Une Intelligence Artificielle Générale c’est une IA qui est capable de faire comme un humain sur tout.

Cette IA peut se gérer de manière autonome et accomplir des objectifs.

Généralement quand une personne pense à une IA aujourd’hui, elle pense à ça.

C’est ce qui fait que ChatGPT nous a mis une claque : ça ressemble à une IA Générale.

Le paradoxe c’est que ChatGPT part bien d’une IA Étroite : il prédit du texte super bien. On en reparlera quand on parlera de son fonctionnement. Mais on commence à flirter avec la frontière. Parce que le langage est un outil puissant qui peut quasiment tout faire.

Ceci dit… on y est pas encore.

La question c’est : est-ce que c’est possible ?

L’autre question c’est : est-ce souhaitable ?

Niveau #3 : ASI

Ici le S est pour Super.

On pourrait aussi dire Surhumaine.

Alors là… c’est l’IA des films. Celle qui peut commencer à faire des trucs qui ressemblent à de la magie, comme créer de la matière en réorganisant les atomes ou résoudre des problèmes qui nous paraissent insolubles.

En réalité, nous sommes incapables de décrire ce que ferait une IA Surhumaine. De la même manière qu’une araignée ne pourra jamais comprendre ce qu’est une maison. Que ce sont les humains qui les construisent et que ça ne fait pas partie du décor naturel. Une araignée ne peut même pas soupçonner l’existence de l’écriture.

On ne sait même pas si une telle IA serait le début d’une ère de prospérité pour nous ou si elle nous exterminerait tous d’un coup.

Et… pour ne rien arranger…

On ne sait pas combien de temps il faut à une AGI pour devenir une ASI

On a dit qu’une AGI c’était une IA du niveau d’un humain. Mais imagine ce que pourrait faire une intelligence de niveau humain sans la fatigue et la limite physique.

Une AGI pourrait travailler sans s’arrêter sur un problème et se dupliquer pour être à plusieurs sur le même problème. Rien que ça c’est déjà fort.

Mais surtout… on ne sait pas combien de temps il lui faudrait pour s’auto-améliorer. Une fois qu’une IA atteinte le niveau humain, peut-être qu’il lui faut seulement quelques heures pour atteindre le niveau surhumain.

Mais là encore ça semble encore faire du niveau humain un truc spécial.

On a demandé à des scientifiques de faire la prédiction

Il y a dix ans, on a posé la question à des scientifiques expert·es de l’IA. On leur a demandé d’attribuer des probabilités à des affirmations.

“Il faudra moins de 2 ans à une AGI pour devenir une ASI” : 10%

Comme on le disait plus haut, croire que ça serait quasiment instantané comme le pense les plus enthousiastes c’est un peu revenir à l’illusion du niveau humain comme spécial. En revanche :

“Il faudra moins de 30 ans à une AGI pour devenir une ASI” : 75%

Ça semble être la durée qui fait globalement consensus.

Dans le même sondage on leur a demandé de donner une date optimiste pour l’arrivée de l’AGI, une date réaliste et une date pessimiste. Ça a donné :

Optimiste : 2022

Réaliste : 2040

Pessimiste : 2075

Bon… on est en 2025 donc on sait que 2022 n’a pas été l’année où une IA Générale est apparue même si, c’est marrant parce que c’est l’année où GPT a été distribué au grand public.

Si on extrapole les deux questions ça nous donne donc une ASI qui arrive entre 2042 et 2070 de manière réaliste. Et entre 2077 et 2105 de manière pessimiste.

Attention ici « réaliste » et « pessimiste » n’ont aucune valeur scientifique, c’est l’estimation que les personnes ont fait.

D’ailleurs, il y a 2% des scientifiques sondé·es qui ont répondu que l’IA Générale n’existera jamais. Que c’est tout simplement impossible.

Catastrophe ou bénédiction ?

Comme je le disais plus haut, nous ne savons pas dire si l’apparition d’une IA surhumaine serait un événement ultra-positif ou catastrophique pour l’humanité.

Mais pourquoi ? Après tout si c’est nous qui la créons, pourquoi y aurait le moindre risque ? Et surtout, si y’a un risque pourquoi on hésite sur le risque ?

Et bien c’est à cause de ce qu’on appelle le problème de l’alignement. Mais on en parle demain.

Ma source principale

Tout ceci est une paraphrase d’une partie de l’article de Waitbutwhy :

Bonjour à toustes, bonjour Nicolas,

Alors pour avoir quelques bases concernant l'aviation, j'ai des doutes sur la phrase:

"Le logiciel qui fait atterrir les avions est une #ANI"

Cela existe depuis les années 60's et n'est à mon avis rien d'autre que plusieurs automates qui suivent des consignes sous la surveillance des pilotes

https://en.wikipedia.org/wiki/Autoland

Par contre les prédictions (à la fois des spécialistes et des predictions markets) ont laaaargement évolué depuis 10 ans.

Les prédictions pour l'AGI sont plutôt dans la tranche 1-3 ans.

L'ASI c'est plus difficile à dire, mais dans la mesure où GPT4-o3 a déjà le niveau du 175ème meilleur codeur du monde, et où la version suivante aura probablement un niveau top 10, on ne peut que supposer que l'accélération va s'intensifier.