GPT est-il intelligent ?

Il y a 15 ans, j’ai découvert le concept du Test de Turing. Ça m’avait fasciné et j’étais convaincu que c’était une bonne manière d’évaluer si une machine était intelligente. En quoi ça consiste ? Et bien c’est l’idée de dire que si une machine est capable de se faire passer pour un humain lors d’une conversation.

On demande à un humain d’avoir une conversation avec A et B. Il sait que l’un des deux est une machine et l’autre un humain. Sa mission consiste alors à déterminer qui est la machine et qui est l’humain.

Une machine est intelligente si elle arrive à tromper suffisamment d’humains lors de ce test.

J’ai découvert ce concept en me baladant sur Wikipédia et j’avais trouvé ça très convaincant. Bien sûr j’avais sauté la partie critiques de la page. Ce n’est absolument pas un test qui fait l’unanimité dans la communauté scientifique.

D’ailleurs… ChatGPT a réussi ce test. Ça ne t’étonnera probablement pas si tu as déjà utilisé GPT.

Et pourtant je ne dirais pas encore que ChatGPT est intelligent au moment où j’écris ce texte.

Mais déjà… ça fonctionne comment GPT ?

ChatGPT repose sur la prédiction de texte

Contrairement à ce qu’on pourrait croire, ChatGPT ne fonctionne pas comme un algorithme d’échecs avec des arbres des décisions, etc. En tout cas ce n’est pas son moteur.

Son moteur a une mission simple mais difficile : prédire la suite d’un texte à partir de ses données d’entraînement.

Chaque mot est important ici. Premièrement ça veut dire que le moteur de ChatGPT ne peut se servir que de données sur lesquelles on l’a entraîné. C’est ce que veut dire le P de GPT : pre-trained.

Y’a des humains qui vont entraîner le moteur jusqu’à ce qu’il fasse des bonnes réponses. Déjà là ça pose un point crucial. Ça veut dire que ce sont des humains qui ont appris à GPT ce qui était une bonne réponse. Rappelle-toi de ça quand tu veux l’utiliser comme un truc objectif qui permettrait d’avoir la réponse à un débat.

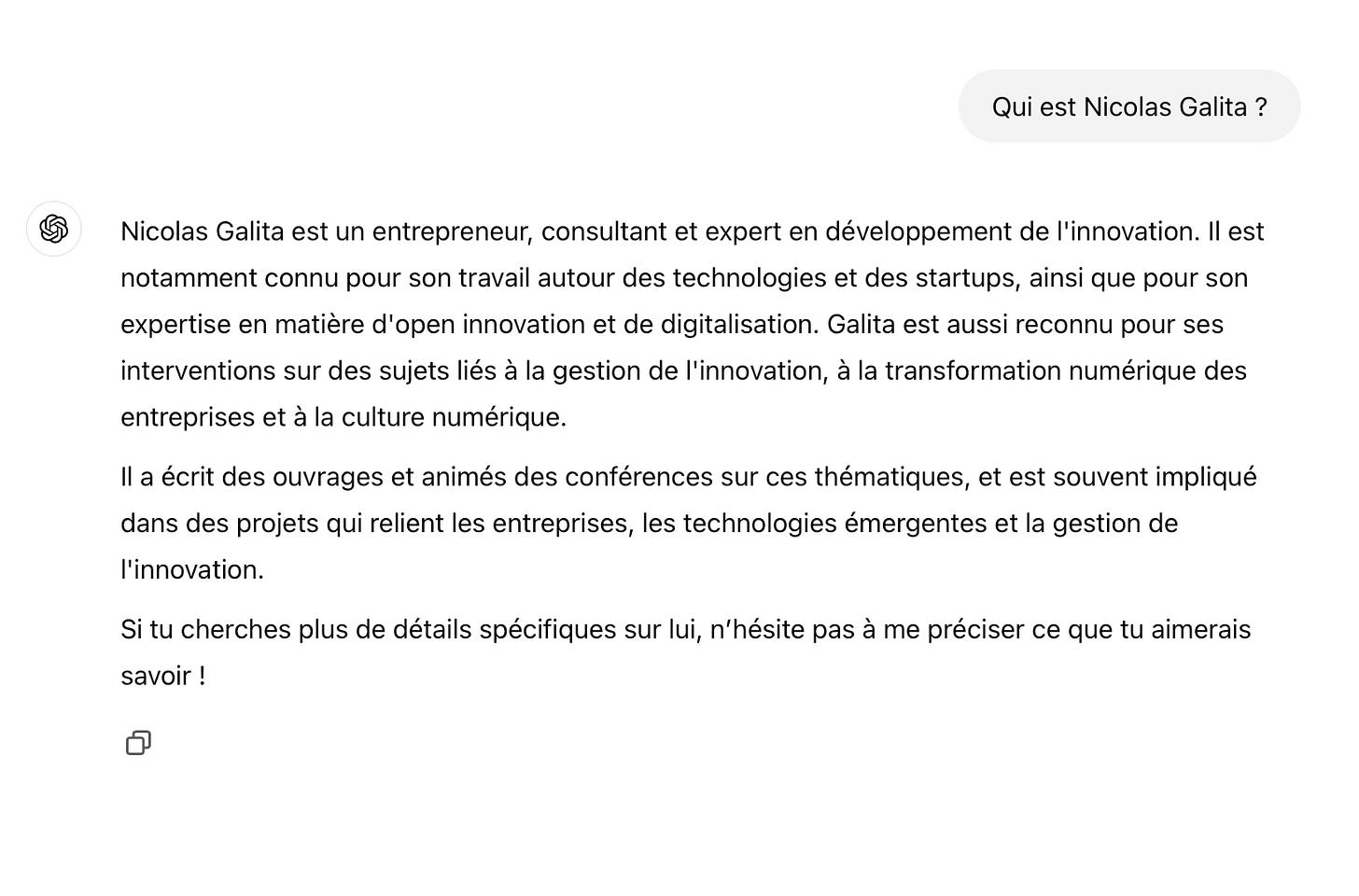

Deuxièmement, et c’est le plus important, le moteur de GPT ne fait qu’une seule chose : prédire du texte. D’ailleurs, au tout début, quand j’écrivais dans ChatGPT qui est Nicolas Galita, il répondait des trucs comme Nicolas Galita est un fameux chanteur de reggae qui…

Parce que c’est effectivement une suite crédible à ce texte.

Bon… ça c’est le moteur de base, mais on rajoute des couches supplémentaires pour faire un truc plus complexe qui, aujourd’hui, si je lui dis Qui est Nicolas Galita il comprend qu’il doit sortir de ses données d’entraînement et aller chercher sur le Web pour faire la bonne réponse.

Mais c’est important de garder en tête le fonctionnement profond. Il explique des trucs surprenants sans ça.

Par exemple :

Alors… oui, c’est vrai que j’ai travaillé un peu dans le domaine des startups… mais c’est si marginal.

Pire encore, si je lui demande pour ma sœur qui, contrairement à moi, n’a pas de grosse présence numérique, ça donne ça :

Alors là… y’a vraiment rien qui va. C’est ce qu’on appelle une hallucination (c’est le vrai terme technique). Comme il n’a pas Johanna dans ses données d’entraînement alors il est obligé d’inventer. Il n’est pas capable de déterminer un truc vraiment probable. Même s’il essaie : on remarque qu’il dit qu’elle est française et que c’est une journaliste, qu’elle est à la fois sérieuse et légère…

En vrai c’est pas SI absurde. Pense aux données d’entraînement, c’est-à-dire majoritairement le web… un article qui commence par Qui est Machin Chouette ?

La suite c’est toujours une personnalité. Y’a jamais d’article Qui est Machin Chouette ?

Bah c’est ma sœur, que je vous présente car elle est cool.

Enfin si… tu me diras que y’avait ça dans les Skyblog. Mais c’est l’exception.

La critique de la chambre chinoise

À cause de ce fonctionnement certaines personnes font à GPT la critique de la chambre chinoise.

Ce qui est marrant c’est que cette expérience de pensée a été créée précisément pour critiquer le Test de Turing. La voici :

Dans cette expérience de pensée, Searle imagine une personne qui n’a aucune connaissance du chinois (en l’occurrence, lui-même) enfermée dans une chambre. On met à disposition de cette personne un catalogue de règles permettant de répondre à des phrases en chinois.

Ces règles sont parfaitement claires pour l'opérateur. Leur application se base uniquement sur la syntaxe des phrases. Une phrase d’une certaine forme syntaxique en chinois est corrélée avec une phrase d’une autre forme syntaxique.

L'opérateur enfermé dans la chambre reçoit donc des phrases écrites en chinois et, en appliquant les règles dont il dispose, il produit d’autres phrases en chinois qui constituent en fait des réponses à des questions posées par un vrai locuteur chinois situé à l’extérieur de la chambre.

Du point de vue du locuteur qui pose les questions, la personne enfermée dans la chambre se comporte comme un individu qui parlerait vraiment chinois. Mais, en l’occurrence, cette dernière n’a aucune compréhension de la signification des phrases en chinois qu’elle transforme. Elle ne fait que suivre des règles prédéterminées.

Et c’est vrai que le fonctionnement de GPT fait énormément penser à cette expérience de pensée (qui date des années 80 quand même). Ça semble même être exactement ce que fait ChatGPT.

ChatGPT applique des règles de probabilité pour renvoyer du texte, mais ça ne veut pas dire qu’il comprend.

Sauf que…

L’argument n’est-il pas de mauvaise foi ?

En effet… ChatGPT ce n’est pas l’humain dans la chambre chinoise, ça c’est plutôt son moteur ou alors les processeurs du serveur où il est exécuté. ChatGPT c’est toute la chambre chinoise.

Or… il est irréfutable que la chambre chinoise parle chinois. Peu importe que le bonhomme à l’intérieur ne parle pas chinois.

Certaines personnes répondent que la chambre fait semblant de parler chinois. Mais quelle est la différence ? Ça commence à devenir technique. Au final… un humain qui parle chinois, il fait exactement pareil, non ?

Il a dans son cerveau des neurones qui, individuellement ne comprennent absolument pas ce qu’est le chinois. Chaque neurone effectue une mini-tâche et ensuite le cerveau va synthétiser tout ça.

Pourtant personne ne dit un humain ne parle pas vraiment le chinois puisque chacun de ses neurones est incapable de parler le chinois.

Au final ce qu’on veut dire c’est que ChatGPT n’est pas conscient de parler chinois.

Ça c’est autre chose.

Il me paraît difficile de nier que ChatGPT nous parle. En revanche on peut se demander s’il a une conscience.

L’expérience de ChatGPT qui joue aux échecs

En ayant plein de parties écrites en texte dans ses données d’entraînement, GPT est capable de jouer aux échecs. Alors… il joue à un niveau de joueur moyen de club. Il est très très loin des IA d’échecs qui aujourd’hui sont toutes beaucoup plus fortes que le joueur humain le plus fort du monde.

Mais… ça reste plus fort que l’écrasante majorité des humains.

Bien sûr, comme il peut halluciner, il propose de temps en temps des coups illégaux.

Là où ça devient intéressant c’est que, grâce à une technique que je suis incapable de t’expliquer correctement, on a été capable de mesurer avec des sondes si GPT avait créé une représentation « mental » d’un échec.

Et… la réponse est oui.

GPT ne se contente pas de prédire à partir des données d’entraînement, il s’est créé dans sa « tête », un échiquier pour pouvoir « voir » ce qu’il fait.

Ça ne prouve pas qu’il est conscient, mais ça donne un argument de plus vers un truc qui ressemble.

Sources

Le fonctionnement du moteur de ChatGPT

L’argument de la chambre chinoise

ChatGPT se crée une représentation de l’échiquier

Perso je ne vois aucune raison de penser que ChatGPT n'est pas intelligent, mais évidemment ça dépend de la définition qu'on donne à intelligence. Si on lui donne quelque chose de très théorique je veux bien, mais à mon sens ça ne tient pas l'analyse.

Comme tu dis : la boîte parle chinois, même si l'humain à l'intérieur ne comprend pas.

Par contre, l'arrivée des IA assez oufs (surtout à partir de GPT4o et Claude 3.5) m'a convaincu d'une chose : l'intelligence n'est pas liée à la conscience.

A mon sens les LLM dernière génération sont déjà très largement plus intelligents que la plupart des êtres humains (l'expérience empirique tout comme les benchmarks le prouvent, par exemple GPT4-o3 bat les PhD dans leurs domaines d'expertise), et pourtant ils ne sont pas conscients (je pense 🙃).